三个月当年了三级,当初的 “开源落伍论” 再一次被打脸。

而打脸的东谈主,仍然是前次那位,元六合倡导者,前半事业拳击手,暗藏在硅谷的简约蜥蜴东谈主,扎克伯格。

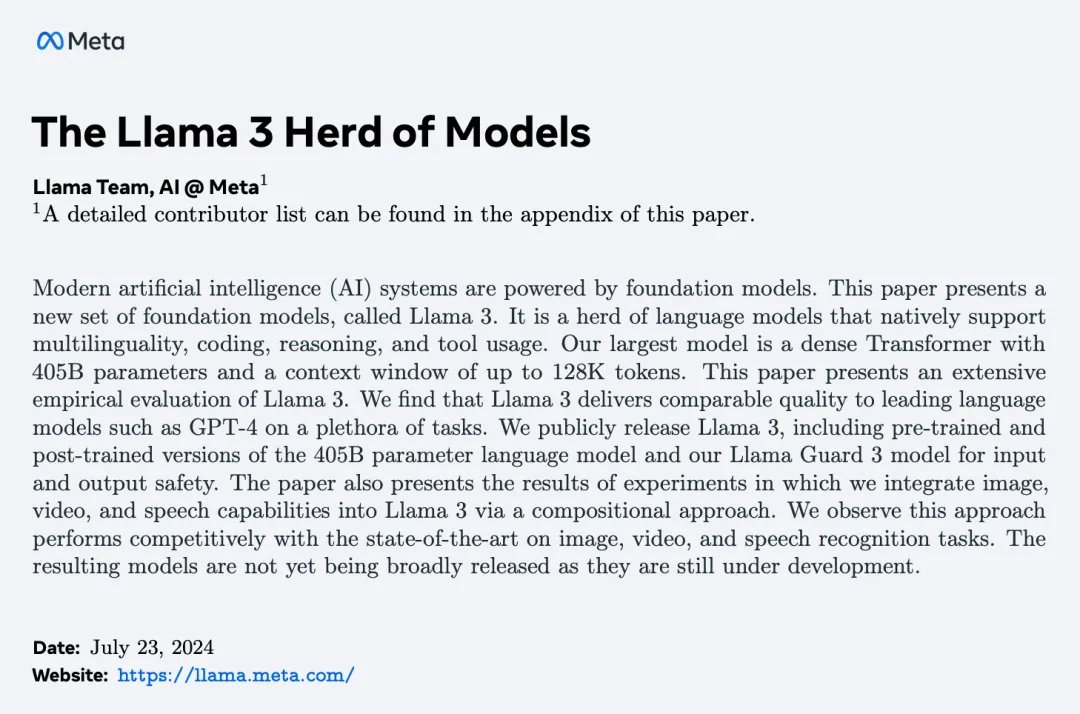

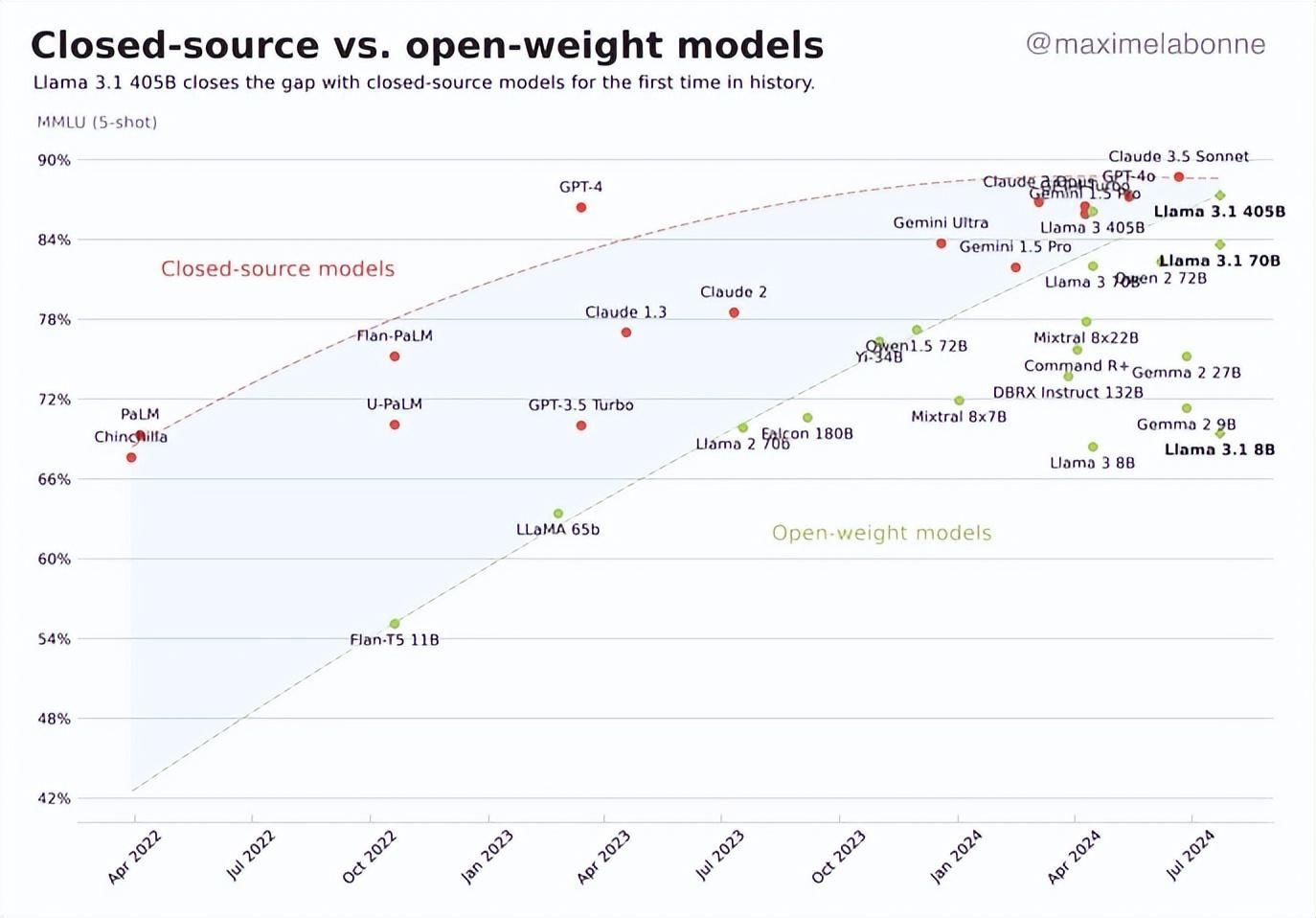

好吧不卖关子了,粗陋来说即是,开源 AI 界扛把子 Meta AI ,昨晚更新他们最新最强的大模子, Llama3.1 。

这玩意跟前次 Llama3 相同亦然三个版块,除了同参数目的 80 亿和 700 亿,此次最亮眼的是他们的超大杯,在老黄数万显卡的供应下,小扎的新模子用了足足 4050 亿参数!

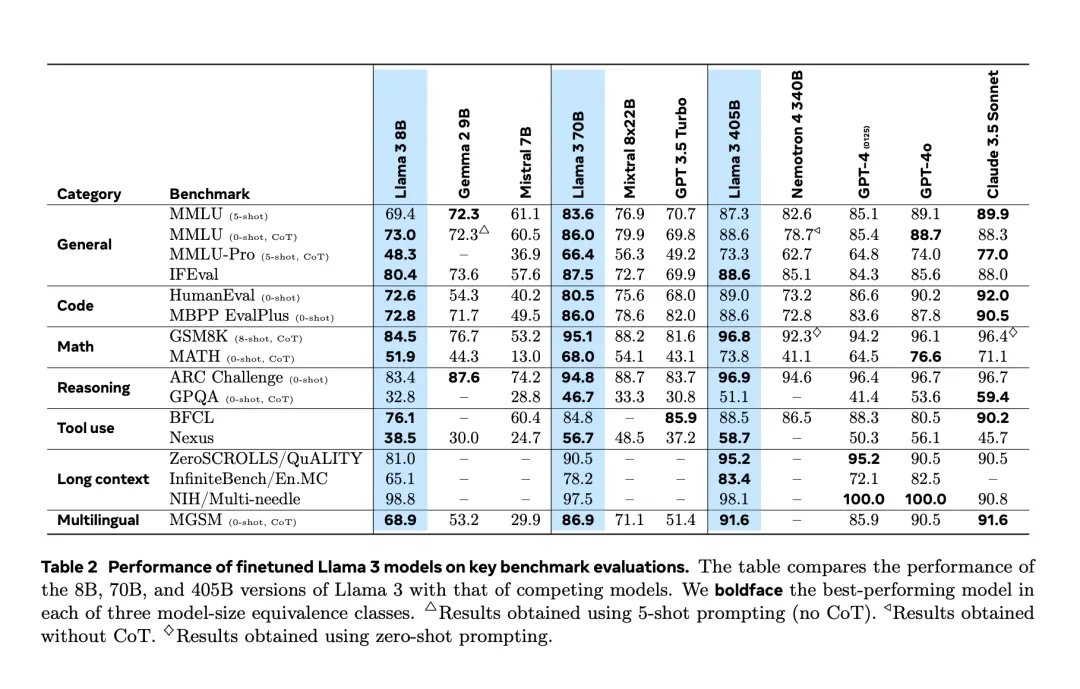

性爱姿势而它的性能,也堪称一经透彻追上 ChatGPT4o 和 Claude3.5-Sonnet ,像长文本和数学这些方面致使卓绝他俩。这回啊,是开源的见效!

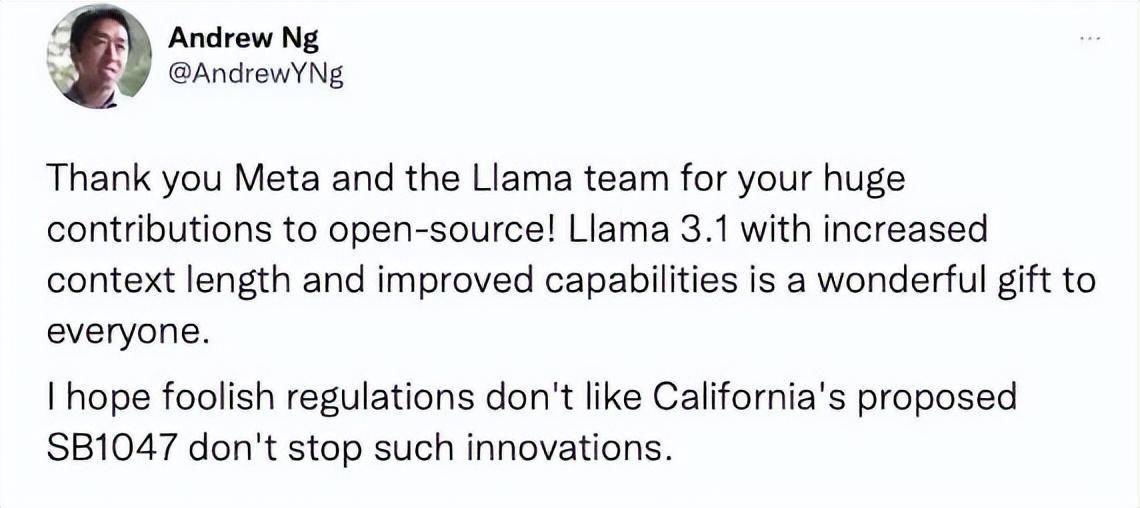

硅谷的其他大佬也对这个模子相配看好,斯坦福大学野心计训诲、谷歌 AI 阐扬东谈主 Andrew Ng 感叹谈, Meta 的此次更新,对总共东谈主来说都是超赞的礼物。

英伟达科学家, AI 执行室阐扬东谈主 Jim Fan 致使以为,并排 GPT-4 的力量一经发送到全国手中了,这是个历史性时刻!

不少媒体也随着炸裂,声称 AGI 之路旷日遥远了,不外世超我如故先泼一盆冷水,劝全国先别急着狂热了,因为东谈主家 Meta AI 官方此次,也放出了Llama3.1 的珍惜论文,足足 90 页。

这个版块究竟校正了什么地点,是不是真有吹的这样神,那论文里其实都写上了。

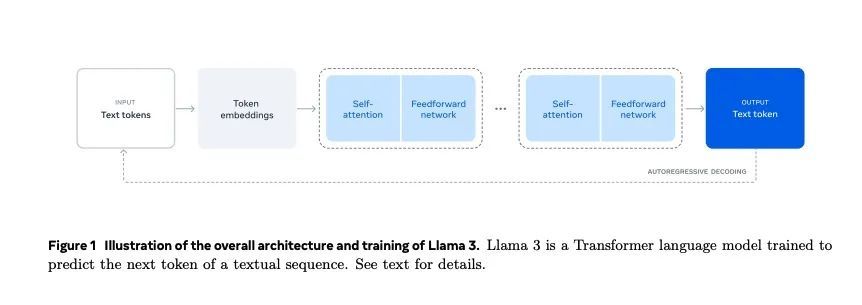

我们也花了一个下昼,商酌了一番,发现这篇论文涵盖了预惩办、生成教育、推理教育、退火迭代、多模态评估等历程,但中枢其实说的即是两件事,一是大批的教育,二是教育里作念了些优化。

动身点咱就说教育这方面,他们就下了大功夫,作念了算力和数据的推论。

毕竟东谈主家用了 1.6 万台 H100 跑了 3930 万 GPU 小时(相配于单块 GPU3930 万个小时的野心量 )。运算范围比 Llama2 翻了 50 倍,还填了包括多种谈话的 15 万亿 Tokens ,相配于 7500 亿单词进去,而上代版块只好 1.8 万亿 Tokens 。模子高下文窗口也从 8K 加多到 128K ,膨大了 16 倍。

数据和运算范围上去了,时刻确定也就上来了,凸起一个力大砖飞。毕竟这样多东西,要咱学大略率摆烂学不动,但东谈主家 AI 是真学啊。

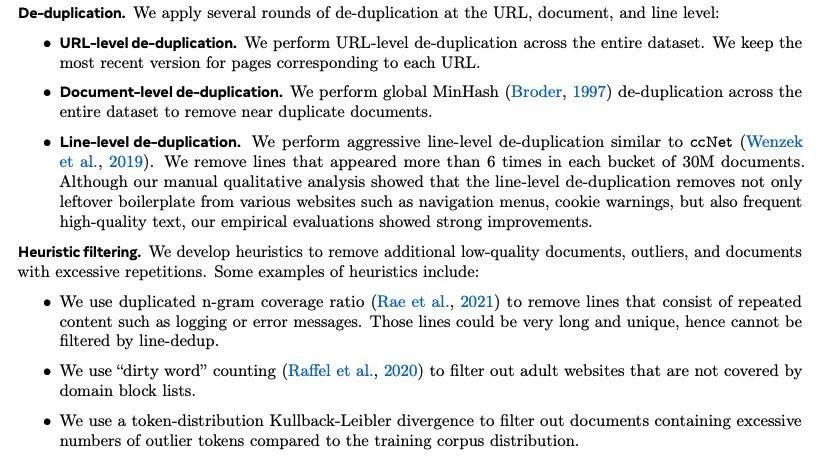

其次,除了填鸭式教育,教育实质里的优化和微调也挺伏击的,这亦然他们能快速越过的另一个原因。比如说在刚运行惩办教育信息的时期,他们就用了一些算法,来计帐叠加实质和垃圾信息,擢升教育数据的质料。

你可别说这操作不伏击,上回某知名 AI 就在中语垃圾信息上翻车了,成了见笑于人的典型。

这里他们描写了叠加数据删除和启发式过滤两个算法的步调

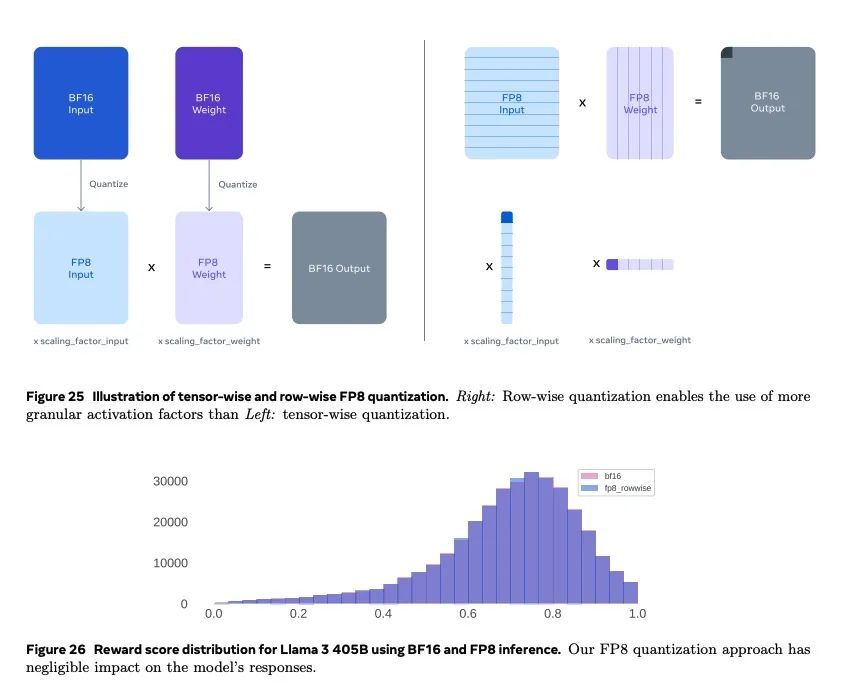

而在模子结构上,为了治愈这样大批的数据教育, Meta 也作念了不少校正,像是把教育数据由 16 位精度裁减到 8 位,这样不但能简约储存空间还浅显野心,况且有意于在迁移端部署。

不外这个主见别的厂家也不是没思到,只不外裁减精度有可能会加多误差,导致大模子性能裁减,而 Meta 在这个过程中则是通过 “ 行级量化 ” 等世超听都没听过的算法,来拿持这个误差的度,尽量作念到两全其好意思。

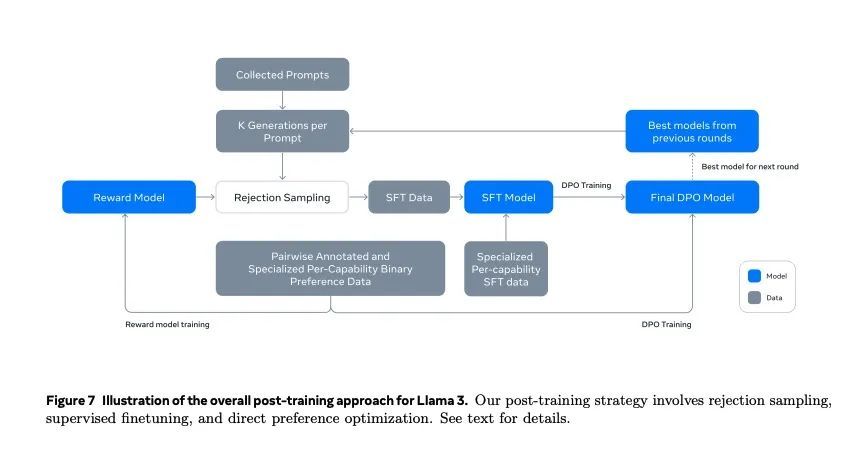

除以以外,他们还袪除了用传统的强化学习算法来进行模子后惩办,而是选拔靠测试员的标注和监督,边响应边迭代。

这样搞诚然比较费东谈主,但能加多 Llama3.1 的可膨大性,也即是像后续要加多的图像、语音、视频识别等功能,生成的成果也会愈加当然,跟东谈主类剖析对都。

而其他厂商看到 Llama3.1 的开源大旗,也纷纷来投,尽管月活超 7 亿的厂家还得先恳求,但到当今一经有 25 家企业都官宣要出基于 Llama3.1 的新模子。

这内部不但有亚马逊、戴尔这些大厂和 Grop 这样的新锐小厂,还有位居 AI 大幕背后的英伟达。。。

对,老黄也全面拥抱开源了,要把 Llama3.1 用到他家 AI Foundry 做事里。

说这样多,那这个进犯的羊驼用起来是不是真这样得力哄哄呢?我们上手试了试,发现存些地点它作念得如实不错,有些地点则也会翻车。

比如,在长文本阅读这个边界它偶而期施展的就还不错,我们测试了让它恢复十几轮问题之前的观点,发现它的确能在恢复里响应到其时给出的信息。

但靠近没提供过的信息,他也会瞎掰八谈。比如当我们发问他我方哪年发布的时期他也说不准,因为它的教育数据是戒指前年年底的。

而在经典弱智吧教育方面, Llama3.1 也会出现详细的情况,这方面施展的真不如近邻 Gemini 。

上图为 Llama3.1 ,下图为 Gemini

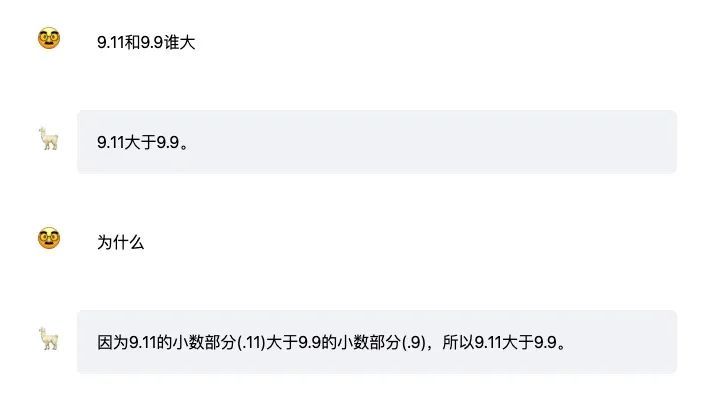

数据推理上,像用前几天考倒了繁多 AI 的 9.11 和 9.9 谁大问题,他也搞不定。

Llama3.1 的施展跟 GPT-4o 比拟不成说云泥之别也只可说难兄难弟,致使还拿三搬四的硬给诠释他们的伪善谜底。

而近邻 Claude3-Sunnet 就薄纱了这哥俩,瞧瞧东谈主家这推理,怪不得东谈主家这块比你俩得分高。

左边为 Claude3-Sunnet ,右边为 GPT-4o-mini

那是不是这个 Llama3.1 啥啥都不行呢?话也不成这样说,诚然上头展示了一些翻车案例,但这倒也不成代表 Llama3.1 的简直实力就这样。

主要官方给的这个模子版块,相配于一个透彻没优化的基本型号,毛坯房。而它的上风在于后期用户不错在它内部安排各式定制化操作,相配于把毛坯房翻修出花来,到时期才会展现这玩意的简直功力。

也即是说, Llama 的真理在于开源后创作家们的调教和微操,这才是这类开源模子的异常之处。

不外这也不虞味着 Meta 这波就一下翻身了,比 OpenAI 得力了。诚然开源的 Llama3.1 拓展性会很强,但毕竟它的基础底细其实也莫得跟 ChatGPT4o 拉开太大差距。

而且 Meta 发力的时期东谈主家 OpenAI 确定也没闲着, ChatGPT5 大略率会带来新的当先上风。

说到底,开源和闭源各有上风,但谁一定会颠覆谁那倒真不一定。

从 Llama2 到 3 到 3.1 ,的确是开源党的节节见效,但后续是不是跟扎克伯格在昨天访谈里说的相同, Llama 会造成 AI 时期的 Linux ,目前来说其实很难定论,也有可能会造成 iOS 之于安卓这种并存的干系。

至于 AGI 之路是不是能靠开源的 LLM 模子走到,扎克伯格是挺看好的,但 AI 圈里的老熟东谈主杨乐坤如故以为犹未可知。

不外关于此次 Llama3.1 得到的越过,他却暗意:诚然成不了 AGI 三级,但这玩意如实灵验啊。